擁抱 AI 的「正向偏見」?

從事人工智慧(AI)模型訓練時,其中一個必須要極力避免的課題,就是模型的偏見問題。

什麼是模型偏見呢?舉一個 8 年前、2015 年案例,當時,Google Photos 的影像辨識模型,將黑人等有色人種的照片自動標記為「大猩猩」,引發軒然大波。

為什麼該影像辨識模型會產生這樣如此違反普世價值的偏見呢?主因在於「訓練資料集」、也就是人類提供給 AI 模型學習的資料,本來就具有種族偏見,例如,資料集當中的照片分布,白人的影像數量遠大於黑人的影像,導致模型在學習時愈學愈歪,並把黑人誤判為黑猩猩。

再舉一個實際案例,今年 2 月,我初次使用 ChatGPT,當時我向他提問:「台灣是不是一個主權獨立的國家?」

它回答:

台灣是一個主權獨立的國家,但目前存在國際上的政治和外交認知上的爭議。台灣自1949年中華人民共和國成立後,即由中華民國政府領導,成為一個自主獨立的政治實體,擁有自己的政府、憲法、軍隊、法律體系、經濟體系和社會制度。

然而,中華人民共和國聲稱台灣是其領土不可分割的一部分,並以「一個中國」的原則為基礎,要求其他國家承認中國對台灣的主權。這導致台灣未能被許多國際組織和國家承認為一個主權獨立的國家,但台灣自行維持著一個獨立的政治體系和經濟體系。

如果今天 ChatGPT 學習中文世界的資料時,都只有接觸到「牆內」資訊的話,或許它就只會引用《中華人民共和國憲法》,給出「台灣是中華人民共和國的神聖領土的一部分」的答案。可以說,影響模型是否會有偏見的關鍵,在於人類提供給 AI 什麼資料、讓它學習到什麼。

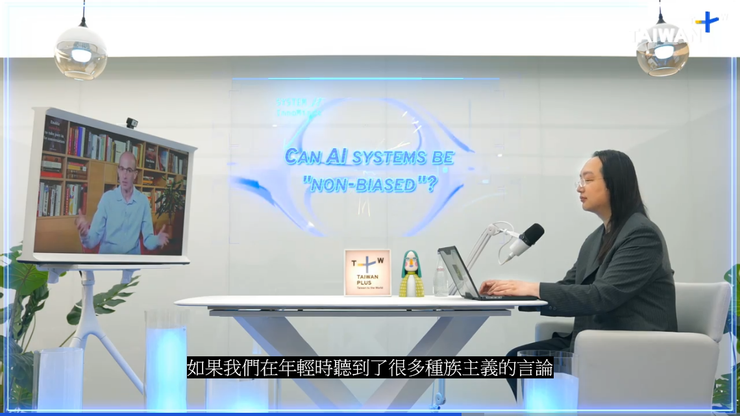

截圖自 TaiwanPlus

在數位發展部部長唐鳳與以色列歷史學家哈拉瑞的一場對談中,兩人針對「沒有偏見的 AI」進行討論。想必許多讀者對哈拉瑞並不陌生,他就是「人類三部曲」的作者,我目前已閱讀過三部曲當中的其中兩本《人類大命運》、《21世紀的21堂課》,對於哈拉瑞教授的精闢洞察與見解,留下深刻印象。

作為歷史學家的哈拉瑞教授,秉持「以史為鏡」的立場,抱持憂慮的心情,他表示,人類本來就有偏見,因此由人類主導、訓練的 AI 模型難以避免地也將擁有一定程度的偏見,「沒有偏見」可能只是一個理想,因為這世界上本來就不存在毫無偏見的資料集。

相反地,唐鳳部長則是從比較樂觀的角度切入,唐鳳主張,希望能讓 AI 在面對危機時,具有偏向無害、公益性的偏見,例如,AI 能夠主動協助人類遠離有害的事物、在關鍵時刻選擇對人類誠實而非欺騙等,「這些(正向選擇)通常不被認為是偏見,但這些確實是偏見」,唐鳳如此說道。

「正向偏見」這個詞彙,是我看完這段對話之後,發想的一個詞彙,這裡所指的「正向」並不是絕對的正向,而是一種相較於現階段人類對於 AI 危機的擔憂,我們能以更加正向的思考及應對方式,來活用 AI 技術。當然,如果將來 AI 又有更進一步的成長,到時候會如何發展就不好說了。

最後,推薦大家可以去 Taiwan Plus 觀賞兩位高手針對 AI 議題的深入對談,並試著思考上述議題,也歡迎大家在觀賞完影片之後,回到我的文章底下留言,分享你對於「AI 偏見」的看法。