以前始終認為智慧型手機即使畫素再怎麼高,也難以取代”可換鏡頭”相機。除非手機的鏡頭甚至是快門,有了革命性的翻轉,那就有故事了;偏偏這是現在進行式也是未來進行式。

喜歡拍照的人,相信都很在意”鏡頭”。偏偏光學技術上有它的”know-how”門檻與名牌迷戀神祇,於是乎手機廠與知名光學鏡頭廠商(比如徠卡,蔡司等)合作就很常見。

外力,當然指的是”多鏡頭”的導入;AI技術(說深度學習似乎比較精確)喊的很響亮;也就是影像技術再升級。

畢竟,數位時代的攝影,終究核心是一句話:“數位式影像處理”(Digital Image Processing)

說白話就是數學演算式的運算。越有驚奇的演算式出現,越是能產生異想不到的效果。

記得2018年,華為發表三鏡頭手機;而Apple卻早在2013就取得了三鏡頭的專利(美國專利編號No. 8,497,897;標題為“Image capture using luminance and chrominance sensors”)。

其實,早在2014年,HTC就推出雙鏡頭的M8;結果卻是無功而過。而後來者華為、Apple等卻掀起了風潮。

多鏡頭技術,有它的技術內涵;各家的”設計思想暨理念”也有所差異,因此可見到多種實踐方式,比如說2鏡頭的方式可以有:

. 廣角/標準 + 遠距。

. 廣角/標準 + 超廣角。

. 彩色 + 黑白鏡頭。

以谷歌的Pixel 4為例,係”廣角 + 望遠”的構成;而Pixel 5(包含Pixel 4a 5G)則是廣角(77度) + 超廣角(107度)的結構。

雙鏡頭技術,依照各自技術可以喧囂之處,比如對焦速度、散景(bokeh)、倍焦和透視(Zoom & Perspective)等;其內在的技術學問都很有得瞧,好比說,兩者感應器畫素的不同、光圈的差異、光學穩定度、影像融合的演算式等等,處處皆是文章。

智慧型手機內部的影像感應器尺寸比起相機小很多,然而在畫素上的跳躍卻是非常地驚人;比如說,華為的「P20 Pro」標榜著4,000萬畫素、 ISO102400超高感應度等高規格。小米與三星都喊出超過一億畫素的機款。

請注意一件事,智慧型手機的相機模組與傳統相機有些地方的設計是有很大差異的。相信有很多的內行人多有注意到為什麼手機都在標榜著”大光圈”呢?打著大光圈f1.8(比如iPhone 7 Plus)、f1.7(比如Samsung Galaxy S8)、f1.6(比如LG V30)、f1.5甚至有機會再突破一城。如此大光圈的鏡頭若是在傳統相機與數位相機中,其鏡頭價格可是非比尋常,很昂貴的。手機之所以會如此幹法,是完全有脈絡可以追尋的。

首先,”光圈(Aperture)”,係由光線可以進入相機的開口大小來定義。一般常見到的標示有ƒ/2到ƒ/2.8、ƒ/4到ƒ/5.8等。當光圈之數值越小時,代表進光量越多,當用於夜拍時相當有利。當光圈數值越大時,代表進光量越少,可以得到景深的效果。光圈數值越小,光圈越大的意思。

有在攝影的朋友該知道大光圈的鏡頭會有”散景(bokeh)”的效果。但是,對於智慧型手機來說,使用固定光圈,鏡頭靠近小型化影像感應器,以及一個合理的廣泛的視野。所以,手機相機的景深幾乎不會那麼淺。f / 2.2的智慧型手機相機實際上僅提供相當於全畫幅相機上的f / 13或是f / 14光圈的景深,該焦段只會產生少量的模糊。現代手機具有增強的散景效果,實際上多是仰賴軟體的功力手段來獲得更具戲劇性的外觀。

雖然大光圈不能夠保證相機的照相品質,較小的光圈值卻可以讓更多的光線到影像感應器,這可以降低快門的速度以減少模糊的現象,並降低感應器的雜訊。

手機相機的光圈值應該與像素大小合併一起來考慮,因為較大的像素不一定需要大的光圈來捕捉足夠的光線。然而,小像素和小光圈的確是會造成低光性能的問題。因此,手機相機的”光圈 - 鏡頭”品質;會是相當重要的設計環節。特別是如何來避免”像差失真”(aberration distortion)和”鏡頭眩光”(lens-flare)等效應問題。

『像差失真』,是光學上的一門深學問,像差失真有多種的效應。比較為人所孰知的包括有:球面像差(降低清晰度和尖銳度)、Comatic像差(模糊或拖尾)、場曲(Field curvature - 在邊緣失去焦點)、以及引起未聚焦的顏色和分裂白光的色像差(chromatic aberration)等。

無論是相機還是手機的鏡頭,係由多數個“校正群組”所構建的,旨在能夠正確聚焦光線並減少這些像差。便宜的鏡頭模組傾向於使用較少的群組,因此更容易發生問題。還有,透鏡所使用的材料,也扮演著非常重要的角色,更高品質的玻璃以及多種塗層的方式,能夠提供更好的校正效能和更少的失真。光學鏡頭素質的重要性,無庸置疑。

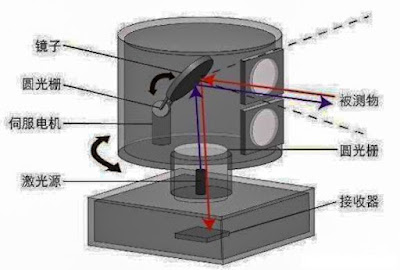

棱鏡(prism)以及透鏡陣列,係具有光學的穩定性,也就是說它們以微小的步幅移動以抵消任何可能的相機震動。

當在手機相機上使用變焦拍攝時,”穩定性”就相當重要。因為在這些情況下,即使是微小的振動和晃動都會導致了模糊的照片。因此,”OIS(Optical Image Stabilization)”的技術將是決定勝負的關鍵。一般是在廣角鏡頭上使用光學防震的技巧,OPPO採用了新方法,並將光學防手震OIS直接應用於長焦鏡頭。事實上,該項技術是源自於以色列新創公司Corephotonics。也就是一狀告Apple的iPhone 7 Plus 及iPhone 8 Plus使用雙鏡頭相機侵犯其專利技術的公司。

常用手機防手震的技術有”電子防手震EIS”與”光學防手震OIS”之區分,前者需要龐大記憶體容量與耗費處理器效能。

手機雙鏡頭的設計,於倍焦上的應用,有著重要的地位。畢竟,手機的拍照訴求已經是目前競爭廠商產品差異化的路途。設計上一般約是等效如27mm焦距,來取得影像。這些鏡頭(往往是安裝在鏡筒中的五個或六個鏡頭元件的堆疊)具有嚴格的製造限制,以確保能夠大量生產。這種設計上的約束導致於表示鏡頭全長的TTL(Total Track Length) 大於鏡頭組件的有效焦距EFL(effective focal length)。

TTL是決定相機高度以及手機厚度的關鍵性參數 !

因此,盡量減少該數值是非常重要的。儘管如此,典型的廣角鏡頭組件的有效焦距為4.2mm和大光圈(比如說F / 1.8),導致了約5mm的TTL和5.8mm的模組高度。

以2倍變焦的雙鏡頭來說,廣角和遠距模組具有相同的畫素數量,遠距需要有較窄視角(比如說54mm),就需要一個具有較大有效焦距的鏡頭組件,來滿足:

EFLτ =2×EFLω×(畫素大小τ)/( 畫素大小ω)

假設EFL = 4.4mm,畫素大小 = 1.4um 以及畫素大小 = 1.0um;遠距相機的EFL就為6.3mm。一般的鏡頭設計有此EFL會導致模組的設計超過了8mm。

透鏡的尺寸主要由透鏡的焦距(f)以及所需要的視野FoV(field of view)來決定的,這些屬性往往牽連在一起,比如說,影像感應器尺寸與FoV * f成正比。較大的焦距會導致較高的變焦倍數和較長的鏡頭,使得相機更厚。

而從2014年才開始竄出的”Corephotonics”為什麼會這麼火紅,原因之一就在於其傲人的專利技術;比如說,”TTL/EFL的比例小於1”的設計技術(專利 US 9,402,032- 2014)。請參考下圖:

典型鏡頭的TTL / EFL比率約為1.3。在1/3“感應器的單光圈智慧型手機相機中,EFL通常在3.5mm和4.0mm之間,導致70-80°的FoV。假設希望使用雙光圈相機實現2倍光學變焦,自然會使用EFL為3.5mm的廣角鏡頭和EFL為7mm的長焦鏡頭。若沒有應用特殊技術,廣角的TTL約為4.55mm(3.5mm x 1.3),而長焦鏡頭的TTL約為9.1mm(7mm x 1.3)。將9.1mm鏡頭整合到手機可能就要10mm了,廠商怎麼可能會接受此方案呢?

影像感應器,是設計雙鏡頭變焦要慎重考慮的重要因素;廣角感應器的畫素尺寸與遠距感應器的畫素尺寸之間的差異,也決定了變焦倍率(zoom factor)。如果兩者感應器的畫素大小是一樣的,變焦倍率就會基於EFL的比率來決定。比如說,廣角EFL為3.8、遠距EFL為6.8,變焦倍率就是6.8mm/3.8mm = 1.8。如果廣角畫素大小為1.25um、遠距畫素大小為為1.12µm,那麼變焦倍率就可以變成2x了。計算方式如下:

(6.8mm/3.8mm) x (1.25µm/1.12µm) = 2x

接著來談雙鏡頭設計的” 影像融合(Image Fusion)”。

影像融合這門技術的演進也不過約是1970年代末之後開始的事情,它係結合了感應器、影像處理、電腦運算和人工智慧理論的交叉型研究領域,加上小波轉換的運算方式之崛起;應用領泛極為廣泛。

影像融合,簡單說就是將不同感應器取得的同一場景影像,或是同一感應器以不同運作模式或是在不同取像時間下所得到的同一場景影像,融合/合併成一幅影像;優點就是影像的內容會更為豐富。

底下就舉幾個雙鏡頭的應用案例,供您參考。

案例1:”彩色 + 黑白” 雙鏡頭

由於黑白感應器取得更多倍(2.5)的光量,有更佳的解析度與信號雜訊比。影像融合之後,對於”低光”的環境能提供更好的影像品質。

案例2:”廣角 + 遠距” 雙鏡頭

這是模擬一般單眼相機的連續光學倍焦效果。融合的影像將改善沒有遠距的影像到遠距相機的視野FOV (field of view )。視野是指從透鏡看出到物體的角度,更大的影像感應器(或軟片)就有更寬的視野,且能補捉到更多的畫面。

理所當然地,影像融合需要一套好的演算式(algorithm);當然,會存在多種的方式。

影像融合技術也有它面臨的技術挑戰,比如說,演算式為了融合兩個影像,就需要使用相匹配的像素。畢竟難免會出現” 遮蔽(occlusions)”的現象,比如下圖所示:

還有鏡頭的”缺陷(imperfection)”也是一個大問題,例如景深差異的部分,一個鏡頭對焦、另一個鏡頭失焦;就很難找到相匹配的像素。

Olympus於2020/9/30正式與JIP簽約,讓渡相機事業。新設立『OM Digital Solution』公司,JIP持股95%,Olympus持股5%。Olympus這個品牌名,珍重再見 !