我們在「【💎 Message Queue - Kafka 案例篇】如何將檔案流上傳到minio - 完整檔案 」有分享到如何串接起kafka與minio, 雖然在minio上傳的部份尚未完成串流的部份, 但初步的橋接已經完成了, 接下來我們要分享的是如何串流到minio。

付費限定

【💎 Message Queue - Kafka 案例篇】如何將檔案流上傳到minio - 分段上傳

更新 發佈閱讀 5 分鐘

以行動支持創作者!付費即可解鎖

本篇內容共 1705 字、0

則留言,僅發佈於💎 阿Han的Premium軟體技術棧你目前無法檢視以下內容,可能因為尚未登入,或沒有該房間的查看權限。

留言

留言分享你的想法!

阿Han的沙龍

145會員

312內容數

哈囉,我是阿Han,是一位 👩💻 軟體研發工程師,喜歡閱讀、學習、撰寫文章及教學,擅長以圖代文,化繁為簡,除了幫助自己釐清思路之外,也希望藉由圖解的方式幫助大家共同學習,甚至手把手帶您設計出高品質的軟體產品。

阿Han的沙龍的其他內容

2024/08/21

歡迎來到「kafka 案例篇」, 這個章節我們來談談如何從kafka的主題訂閱檔案封包並上傳到minio,對於kafka是什麼並不熟悉的朋友, 也歡迎參考我們的「【🔒 Message Queue - Kafka】串流時代的超入門簡介」, 讓我們在串流時代的技術堆疊上能夠加入kafka的技能, 為即

2024/08/21

歡迎來到「kafka 案例篇」, 這個章節我們來談談如何從kafka的主題訂閱檔案封包並上傳到minio,對於kafka是什麼並不熟悉的朋友, 也歡迎參考我們的「【🔒 Message Queue - Kafka】串流時代的超入門簡介」, 讓我們在串流時代的技術堆疊上能夠加入kafka的技能, 為即

2023/08/26

⏳ 精選好文歡迎收藏學習...

什麼是MQ? 🎁 送給你以下三篇基礎...

【Message Queue】 井然有序的排隊機制 - 基本介紹

【Message Queue - RabbitMQ】模型架構

【Message Queue - RabbitMQ】 不斷的試誤…, 用Docker來

2023/08/26

⏳ 精選好文歡迎收藏學習...

什麼是MQ? 🎁 送給你以下三篇基礎...

【Message Queue】 井然有序的排隊機制 - 基本介紹

【Message Queue - RabbitMQ】模型架構

【Message Queue - RabbitMQ】 不斷的試誤…, 用Docker來

2023/08/21

目的

當消費者和生產者在某個節點故障之下還能夠正常運作。

增加多個節點來擴展訊息的吞吐量。

簡單來說就是打群架,透過多台主機的方式處理龐大的訊息量。

集群的模式有哪些?

Cluster:

不支持跨網段。

可以隨意動態增加/減少。

目前常用的方式。

Federation: 應用

2023/08/21

目的

當消費者和生產者在某個節點故障之下還能夠正常運作。

增加多個節點來擴展訊息的吞吐量。

簡單來說就是打群架,透過多台主機的方式處理龐大的訊息量。

集群的模式有哪些?

Cluster:

不支持跨網段。

可以隨意動態增加/減少。

目前常用的方式。

Federation: 應用

你可能也想看

試聞 Sunkronizo的香氛後,我才發現:原來不是我在挑香,而是香氣更早知道我是誰。原本以為自己最像溫柔的 1 號,真正試香後卻被成熟、冷靜的 3 號選中。其他七瓶香,也意外喚醒我生命中不同階段的八種角色。香氣讓我明白——人生不只直線前進,也能橫向展開,切換更多樣的自己。

試聞 Sunkronizo的香氛後,我才發現:原來不是我在挑香,而是香氣更早知道我是誰。原本以為自己最像溫柔的 1 號,真正試香後卻被成熟、冷靜的 3 號選中。其他七瓶香,也意外喚醒我生命中不同階段的八種角色。香氣讓我明白——人生不只直線前進,也能橫向展開,切換更多樣的自己。

我們在「【🔒 Message Queue - Kafka】不斷的試誤…, 用Docker來嘗試安裝Kafka」有分享過如何透過docker來架設kafka, 那麼在產品化的階段, 我們可能會預先規劃主題(topic)要有多少個partitions…等的配置, 基於一鍵啟動懶人包的原則, 我們希望按

我們在「【🔒 Message Queue - Kafka】不斷的試誤…, 用Docker來嘗試安裝Kafka」有分享過如何透過docker來架設kafka, 那麼在產品化的階段, 我們可能會預先規劃主題(topic)要有多少個partitions…等的配置, 基於一鍵啟動懶人包的原則, 我們希望按

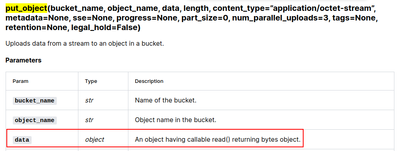

我們在「【💎 Message Queue - Kafka 案例篇】如何將檔案流上傳到minio - 完整檔案 」有分享到如何串接起kafka與minio, 雖然在minio上傳的部份尚未完成串流的部份, 但初步的橋接已經完成了, 接下來我們要分享的是如何串流到minio。

這個實現的關鍵點在

我們在「【💎 Message Queue - Kafka 案例篇】如何將檔案流上傳到minio - 完整檔案 」有分享到如何串接起kafka與minio, 雖然在minio上傳的部份尚未完成串流的部份, 但初步的橋接已經完成了, 接下來我們要分享的是如何串流到minio。

這個實現的關鍵點在

本文介紹如何使用 Docker 安裝 RabbitMQ,並將其與 Node.js 結合,實現訊息的生產與消費。這個架構可以應用於分佈式系統或事件驅動架構中,幫助讀者理解如何整合 RabbitMQ 與 Node.js。

本文介紹如何使用 Docker 安裝 RabbitMQ,並將其與 Node.js 結合,實現訊息的生產與消費。這個架構可以應用於分佈式系統或事件驅動架構中,幫助讀者理解如何整合 RabbitMQ 與 Node.js。

本文介紹如何使用 Docker 部署 Kafka 和 Zookeeper,並透過 Node.js 實現 Kafka 的訊息生產者與消費者。內容涵蓋 Kafka 和 Zookeeper 的 Docker 配置、使用 KafkaJS 進行訊息生產與消費,並透過 API 來發送和接收消息。

本文介紹如何使用 Docker 部署 Kafka 和 Zookeeper,並透過 Node.js 實現 Kafka 的訊息生產者與消費者。內容涵蓋 Kafka 和 Zookeeper 的 Docker 配置、使用 KafkaJS 進行訊息生產與消費,並透過 API 來發送和接收消息。

Generator能夠讓我們在需要資料時才產生資料, 原理很像Kafka的Consumer, 它在處理大量數據時非常的有幫助, 讓我們資料一小塊一小塊的流到目的地, 流式的設計對於串流的應用程式來說非常的重要, 如果您正在設計一套串流的應用程式, 那麼學好Generator會非常的重要, 除了讓

Generator能夠讓我們在需要資料時才產生資料, 原理很像Kafka的Consumer, 它在處理大量數據時非常的有幫助, 讓我們資料一小塊一小塊的流到目的地, 流式的設計對於串流的應用程式來說非常的重要, 如果您正在設計一套串流的應用程式, 那麼學好Generator會非常的重要, 除了讓

相信對於這一篇感興趣的朋友們都已經玩過kafka的Schema Registry了吧! 沒玩過得朋友也沒關係, 歡迎至「【🔒Message Queue - Kafka】傳輸訊息的標準格式制定者 Schema Registry」了解一下這是什麼玩意兒, 好了, 廢話不多說, 讓我們直接切入主題吧

相信對於這一篇感興趣的朋友們都已經玩過kafka的Schema Registry了吧! 沒玩過得朋友也沒關係, 歡迎至「【🔒Message Queue - Kafka】傳輸訊息的標準格式制定者 Schema Registry」了解一下這是什麼玩意兒, 好了, 廢話不多說, 讓我們直接切入主題吧

對於軟體世界中Message Queue有興趣的朋友可以先閱讀這一篇「【資訊軟體知識】井然有序的處理機制 - Message Queue」建立基礎知識之後,再來看看這一篇會更容易進入情境唷!

這次就進入我們一般常見的MQ軟體「RabbitMQ」, 我們先以圖示來了解RabbitMQ的模型架構, 之後

對於軟體世界中Message Queue有興趣的朋友可以先閱讀這一篇「【資訊軟體知識】井然有序的處理機制 - Message Queue」建立基礎知識之後,再來看看這一篇會更容易進入情境唷!

這次就進入我們一般常見的MQ軟體「RabbitMQ」, 我們先以圖示來了解RabbitMQ的模型架構, 之後