有關資料隱私與安全的重點:

付費限定

iPAS-初級AI應用規劃師-資料隱私與安全

更新 發佈閱讀 3 分鐘

以行動支持創作者!付費即可解鎖

本篇內容共 1215 字、0 則留言,僅發佈於AI學習之旅你目前無法檢視以下內容,可能因為尚未登入,或沒有該房間的查看權限。

留言

TN科技筆記(TechNotes)的沙龍

70會員

223內容數

大家好,我是TN,喜歡分享科技領域相關資訊,希望各位不吝支持與交流!

TN科技筆記(TechNotes)的沙龍的其他內容

2025/04/09

114.04.09【成績公告】114年第一次初級AI 應用規劃師能力鑑定開放考生查詢成績

我成功通過了~

2025/04/09

114.04.09【成績公告】114年第一次初級AI 應用規劃師能力鑑定開放考生查詢成績

我成功通過了~

2025/03/18

生成式 AI 在數位轉型中扮演關鍵角色,但導入前需充分了解其能力與限制,並建立完善的風險管理機制。

2025/03/18

生成式 AI 在數位轉型中扮演關鍵角色,但導入前需充分了解其能力與限制,並建立完善的風險管理機制。

2025/03/18

在評估與規劃導入生成式 AI 時,有許多需要注意的事項。

2025/03/18

在評估與規劃導入生成式 AI 時,有許多需要注意的事項。

#AI 的其他內容

你可能也想看

賽勒布倫尼科夫以流亡處境回望蘇聯電影導演帕拉贊諾夫的舞台作品,以十段寓言式殘篇,重新拼貼記憶、暴力與美學,並將審查、政治犯、戰爭陰影與「形式即政治」的劇場傳統推到台前。本文聚焦於《傳奇:帕拉贊諾夫的十段殘篇》的舞台美術、音樂與多重扮演策略,嘗試解析極權底下不可言說之事,將如何成為可被觀看的公共發聲。

賽勒布倫尼科夫以流亡處境回望蘇聯電影導演帕拉贊諾夫的舞台作品,以十段寓言式殘篇,重新拼貼記憶、暴力與美學,並將審查、政治犯、戰爭陰影與「形式即政治」的劇場傳統推到台前。本文聚焦於《傳奇:帕拉贊諾夫的十段殘篇》的舞台美術、音樂與多重扮演策略,嘗試解析極權底下不可言說之事,將如何成為可被觀看的公共發聲。

柏林劇團在 2026 北藝嚴選,再次帶來由布萊希特改編的經典劇目《三便士歌劇》(The Threepenny Opera),導演巴里・柯斯基以舞台結構與舞台調度,重新向「疏離」進行提問。本文將從觀眾慾望作為戲劇內核,藉由沉浸與疏離的辯證,解析此作如何再次照見觀眾自身的位置。

柏林劇團在 2026 北藝嚴選,再次帶來由布萊希特改編的經典劇目《三便士歌劇》(The Threepenny Opera),導演巴里・柯斯基以舞台結構與舞台調度,重新向「疏離」進行提問。本文將從觀眾慾望作為戲劇內核,藉由沉浸與疏離的辯證,解析此作如何再次照見觀眾自身的位置。

本文深入解析臺灣劇團「晃晃跨幅町」對易卜生經典劇作《海妲.蓋柏樂》的詮釋,從劇本歷史、聲響與舞臺設計,到演員的主體創作方法,探討此版本如何讓經典劇作在當代劇場語境下煥發新生,滿足現代觀眾的觀看慾望。

本文深入解析臺灣劇團「晃晃跨幅町」對易卜生經典劇作《海妲.蓋柏樂》的詮釋,從劇本歷史、聲響與舞臺設計,到演員的主體創作方法,探討此版本如何讓經典劇作在當代劇場語境下煥發新生,滿足現代觀眾的觀看慾望。

《轉轉生》為奈及利亞編舞家庫德斯.奧尼奎庫與 Q 舞團創作的當代舞蹈作品,融合舞蹈、音樂、時尚和視覺藝術,透過身體、服裝與群舞結構,回應殖民歷史、城市經驗與祖靈記憶的交錯。本文將從服裝設計、身體語彙與「輪迴」的「誕生—死亡—重生」結構出發,分析《轉轉生》如何以當代目光,形塑去殖民視角的奈及利亞歷史。

《轉轉生》為奈及利亞編舞家庫德斯.奧尼奎庫與 Q 舞團創作的當代舞蹈作品,融合舞蹈、音樂、時尚和視覺藝術,透過身體、服裝與群舞結構,回應殖民歷史、城市經驗與祖靈記憶的交錯。本文將從服裝設計、身體語彙與「輪迴」的「誕生—死亡—重生」結構出發,分析《轉轉生》如何以當代目光,形塑去殖民視角的奈及利亞歷史。

在行動裝置安全日益嚴峻的環境下,保護手機資料至關重要。使用者除了養成良好的使用習慣之外,也需要定期更新手機OS系統來提升資料安全防護力,而企業端也可以透過APP加殼加密的方式,讓APP達到更高水平的防護。

在行動裝置安全日益嚴峻的環境下,保護手機資料至關重要。使用者除了養成良好的使用習慣之外,也需要定期更新手機OS系統來提升資料安全防護力,而企業端也可以透過APP加殼加密的方式,讓APP達到更高水平的防護。

本文介紹如何對 Telegram 憑證監控機器人的代碼進行優化,包括新增指令、讀取變數、提高可讀性和可維護性。

本文介紹如何對 Telegram 憑證監控機器人的代碼進行優化,包括新增指令、讀取變數、提高可讀性和可維護性。

《個人資料保護法》專家孔德澔律師,從「定位功能」帶我們瞭解個資及隱私授權的存在意義以及對生活產生的影響,並分享如何降低風險或是可以善用的地方。

《個人資料保護法》專家孔德澔律師,從「定位功能」帶我們瞭解個資及隱私授權的存在意義以及對生活產生的影響,並分享如何降低風險或是可以善用的地方。

這篇文章分析了PANW法說會提到的資安產業過去10年最大的結構性變化,並探討了雲端和機器學習對資安產業的影響,特別針對雲端、機器學習、network security等議題進行了詳細的分析。

這篇文章分析了PANW法說會提到的資安產業過去10年最大的結構性變化,並探討了雲端和機器學習對資安產業的影響,特別針對雲端、機器學習、network security等議題進行了詳細的分析。

政府、法令是資訊安全的最後防線,本文從政府及法律層面探討網路安全議題,以及資通安全管理法和個資法的重要性。政府擴大進用資安人才,以及執行資通安全管理法、個資法的相關規定,對維護數位平臺安全有著重要作用。除此之外,文章還強調了民眾的資安素養及企業、政府的連手防禦對抗駭客組織及詐騙集團的重要性。

政府、法令是資訊安全的最後防線,本文從政府及法律層面探討網路安全議題,以及資通安全管理法和個資法的重要性。政府擴大進用資安人才,以及執行資通安全管理法、個資法的相關規定,對維護數位平臺安全有著重要作用。除此之外,文章還強調了民眾的資安素養及企業、政府的連手防禦對抗駭客組織及詐騙集團的重要性。

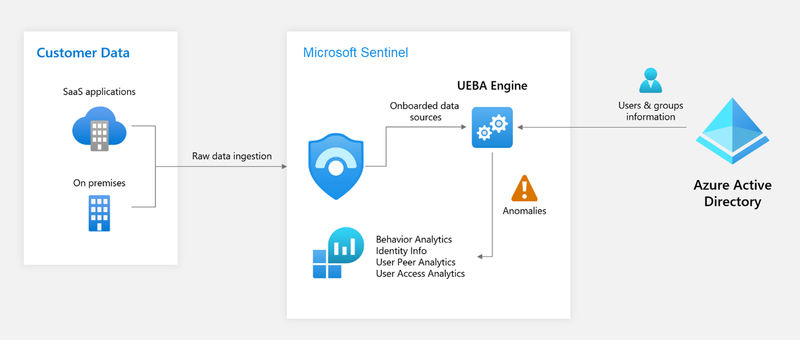

隨着網絡攻擊和資料外洩的種類越來越多,防御方案的部署也要與時並進。近年,很多企業開始留意和測試部署使用者和實體行為分析(UEBA)的可行性。

在資訊保安工作上,內部人員被駭或者內部人員出現錯誤的行為導致企業暴露於風險之中......

隨着網絡攻擊和資料外洩的種類越來越多,防御方案的部署也要與時並進。近年,很多企業開始留意和測試部署使用者和實體行為分析(UEBA)的可行性。

在資訊保安工作上,內部人員被駭或者內部人員出現錯誤的行為導致企業暴露於風險之中......

大數據時代下,Log的多元應用至關重要。Log生成龐大,格式各異,特別金融業需合規。探討Log廣泛應用、資訊安全、IT管理和商業決策。建立Log管理系統核心深入法規,強化IT治理、權限控管。一站式Log管理平台,確保資訊安全合規。

大數據時代下,Log的多元應用至關重要。Log生成龐大,格式各異,特別金融業需合規。探討Log廣泛應用、資訊安全、IT管理和商業決策。建立Log管理系統核心深入法規,強化IT治理、權限控管。一站式Log管理平台,確保資訊安全合規。