儘管深度學習這陣子非常的成功,效果也非常的好, 但每次提到它美中不足的地方時,可解釋性總是被拿來評論一番。今天,我們來針對模型的”可解釋性”這樣一個議題做深入的討論。

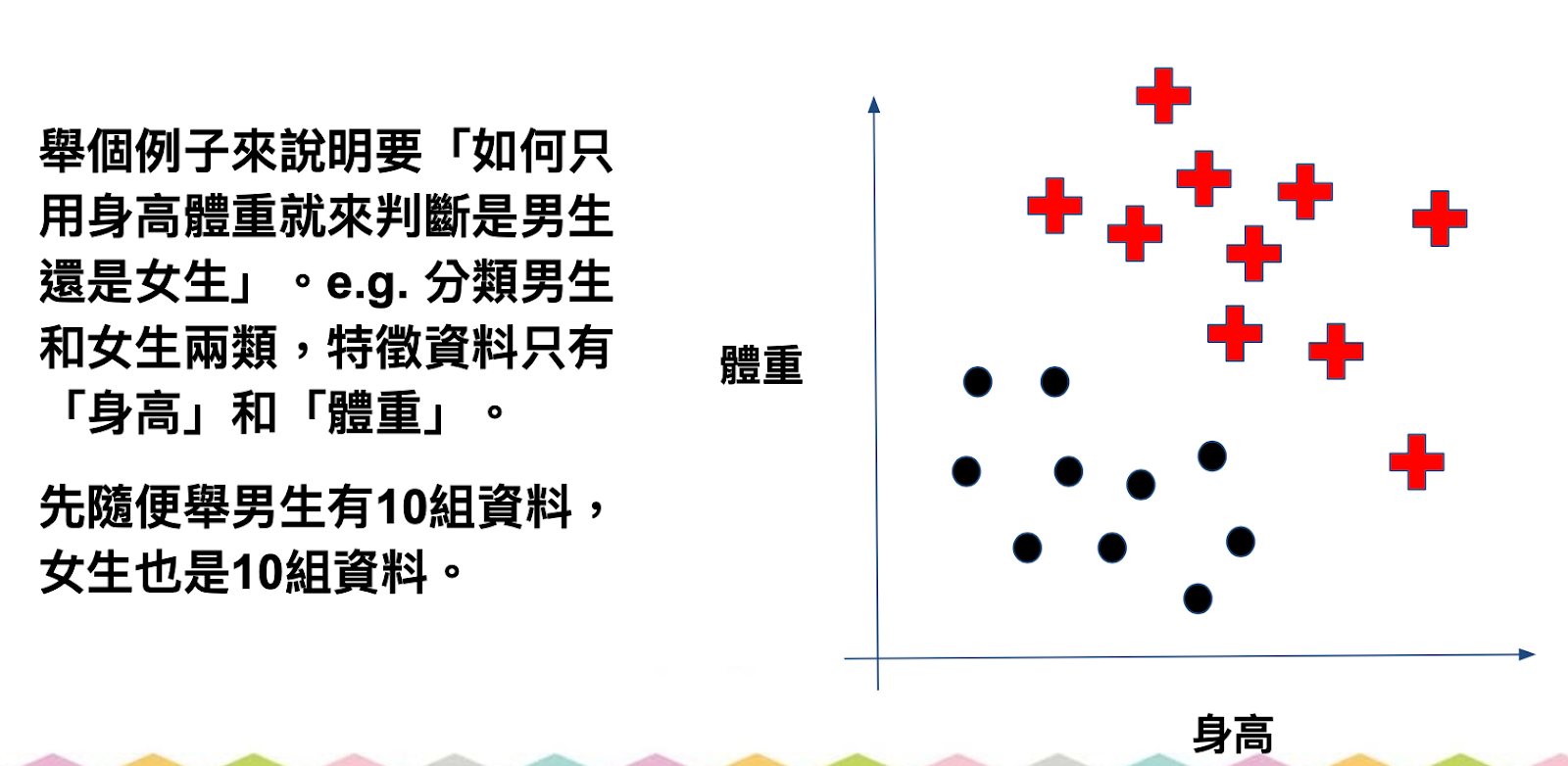

所謂的「可解釋性」,就是當人工智慧演算法做決策的時候,我們是否能夠清楚了解為什麼電腦會做這樣一個決策以及判斷。如果我們可以很清楚的說出電腦判斷的邏輯,那麼我們就說這個演算法的可解釋性很高,反之,如果電腦做決策時,我們只得到一個結果,但對於產生這樣結果的過程我們無從理解,那麼這樣一個演算法的可解釋性就偏低。

那為什麼可解釋性高對於一個模型來說是一個優點呢?因為很多時候,我們除了希望電腦能幫我們做準確的預測外,我們也希望能了解模型究竟從數據裡學到了哪些知識!如果能掌握這些,或許我們對於模型的掌控度就比較高,同時,也可以從中去改良及創新現有的想法。我們都知道,深度學習(又或者稱作類神經網路)可以透過多層神經網路的建構來達到高度擬合複雜的數據集,但對於內部運算的邏輯,往往很難轉換成人類易於理解的形式。儘管深度學習給出來的結果可能不差,但它就如同一個黑盒子,我們並不知道裡面發生了什麼事情,這就如同我們跟老闆呈獻了一個專案報告,但是我們卻無法解釋報告上面的數字是如何計算出來的!身為老闆們,是不是會對這些結果心存懷疑呢?

因此,在某些情況下,傳統的機器學習就會比較受到青睞,例如決策樹(*)這類型的方法就是其中一個例子。在許多金融風控領域裡面,由於可解釋性低意味著更多不確定的風險, 為了精準計算最大可能的損失以及相對應的收益,他們需要非常了解機器在每個環節是如何做決策的,這時候深度學習模型可能就不那麼適合了!

總之,不同的模型會有不同的優缺點,為了滿足各式各樣類型的需求以及限制,我們也必須隨時做出不同演算法的調整及優化阿!

- 決策樹是機器學習裡面一種基於樹狀所產生的演算法,其可解釋性非常的高

*本文由知名AI講師-Isaac Lee 李厚均所撰寫 文章轉載自我們共同經營的粉絲頁-小李談數智https://www.facebook.com/isaac60103

更多圖解內容可以到 耀西圖像視覺化教室看看https://www.facebook.com/YoshiGraphics