安裝 Llama 2

方法1. 使用官方指南安裝 Llama 2

Meta官方提供的Llama 2安裝方法很容易出錯,你需要先在Meta的網站上申請權限,然後執行Git Repository中的shell腳本來下載模型。當你嘗試執行模型時,可能會遇到以下錯誤:

解決方法是到Nvidia的頁面手動下載 NCCL套件,並依照文件上的方法安裝,但我的Mac M2走到這裡就卡住了。

方法2. 使用Ollama安裝Llama 2

Ollama是一個LLM(大型語言模型)的安裝與管理工具,讓你在macOS、Linux和Windows上都能夠輕鬆的安裝LLM。

步驟1. 下載並安裝Ollma

步驟 2. 下載Llama 2

成功安裝Ollama後,你可以使用以下指令下載Llama 2模型。記得更換成你需要的模型版本。

ollama pull llama2:13b-chat

步驟 3. 在Terminal中執行Llama 2

安裝完畢後,只需執行以下指令就能在Terminal使用Llama 2。

在Python中執行Llama 2

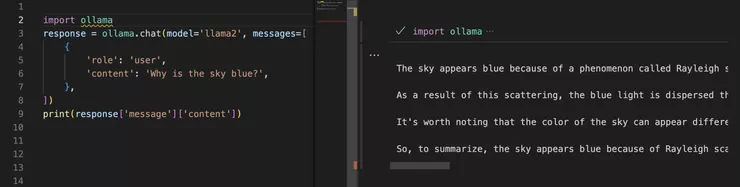

上面的方法是不是超簡單!在Python中使用Llama 2也同樣輕鬆寫意,你唯一需要做的事情就是用pip安裝Ollama,沒了。

pip install ollama完成後就能夠在Python中開心測試Llama 2。

import ollama

response

本文轉載自:ARON HACK - 在本機Python中執行Llama 2與其他開源大型語言模型

本文轉載自:ARON HACK - 在本機Python中執行Llama 2與其他開源大型語言模型= ollama.chat(model='llama2', messages=[

{

'role': 'user',

'content': 'Why is the sky blue?',

},

])

print(response['message']['content'])